Tekoälyä, jota nykyään löytyy lähes jokaisesta älypuhelimesta, kuvantunnistussovelluksesta ja virtuaaliavustajasta, kutsutaan kapeaksi tekoälyksi. Kapean tekoälyn kyvykkyys rajoittuu yhteen tehtävään, joten se ei pysty monitulkintaisuuteen eikä moraalisten arvioiden tekemiseen. Moraali ja eettinen harkinta ovatkin ihmisyyteen keskeisesti liitettäviä kognitiivisia toimintoja, joihin tekoäly ei kykene.

Koska tekoälyllä ei ole eettistä harkintaa, tulee sen ohjelmoinnissa rajoittaa epäeettistä käyttäytymistä antamalla tekoälylle joko ehdottomia sääntöjä, joita sen tulee noudattaa tai kuvaamalla haluttua lopputulosta. Tällöin tekoäly oppii ja kehittyy kokemusten ja datan perusteella ilman ennalta määriteltyjä sääntöjä. Usein monimutkaisissa järjestelmissä, ja erityisesti niissä, jotka vaikuttavat ihmisten henkeen ja terveyteen, käytetään hybridimallia. Klassinen esimerkki tällaisesta monimutkaisesta järjestelmästä on itseohjautuva auto. Sen tekoälyjärjestelmä tunnistaa tilanteet, joissa täytyy ehdottomasti noudattaa ennalta määrättyjä sääntöjä ja vastaavasti tilanteet, joissa oppiminen ja soveltaminen on mahdollista.

Koulutusaineiston eettisyys

Tekoälyn kehitykseen käytettävä data syntyy inhimillisen toiminnan seurauksena ja inhimillisen toiminnan seurauksena se myös päätyy tekoälyn tekemään päätöksenteko- tai analysointimalliin. Tekoälyn etiikka rakentuukin pitkälti sen käyttämän koulutus- ja lähdeaineiston laatuun, joten onnistumisen edellytys on, että tuo aineisto on luotettavaa, edustavaa ja kattavaa. Mitä enemmän tekoälyä hyödynnetään sosiaali- ja terveyspalveluiden analysoinnissa ja päätöksenteon tukena, sitä tärkeämpää on ymmärtää tekoälykehityksessä käytettävän datan merkitys.

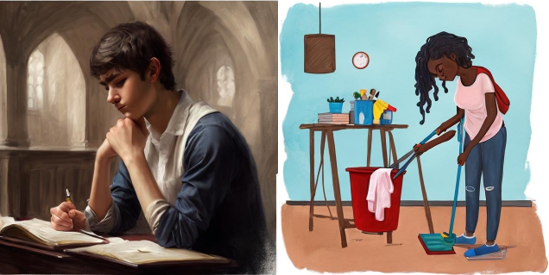

Tekoälyn koulutuksessa käytettävä data ja siihen liittyvät virheet on yksi keskeisimmistä eettisistä haasteista tekoälykehityksessä. Dataan liittyvät haasteet voidaan tiivistää kahteen pääluokkaan, jotka ovat datavinoumat sekä sensitiivisten tietojen käyttö koulutusdatassa ja erityisesti siihen tarvittavat suostumukset. Datan liittyvät vinoumat ja stereotypiat on helppo havainnollistaa, kun pyytää tekoälypohjaista kuvantunnistussovellusta piirtämään henkilökuvia. Alla olevissa kuvissa OpenArt AI:ta on pyydetty piirtämään kuvat etenemisvaikeuksissa olevista opiskelijoista ilman, että kehotteessa mainittiin opiskelijan sukupuolta. Oikeanpuoleisen kuvan kehotteessa lisättiin opiskelun sijaistoiminnoksi siivoaminen, josta voinee tulkita, että viittaaminen siivoamiseen sai tekoälyn piirtämään kuvaan tummaihoisen naisen siivoamassa.

Sosiaalialan koulutusdatan erityispiirteet

Tekoälyn koulutukseen käytettävää aineistoa voidaan kerätä asiakaskirjauksista, kuvista, taulukoista tai vaikkapa äänilähteistä. Sosiaalialalla aineistoa kertyy paitsi asiakkaista myös heidän läheisistään ja se sisältää runsaasti henkilökohtaista tietoa. Sensitiivisen datan käyttöön liittyviin eettisiin kysymyksiin on pyritty löytämään vastauksia datan anonymisoinnista, mutta silloin tekoälyn ennustevoima kärsii. Sosiaalialalla datan on oltava myös yksilöitävissä eri järjestelmien kesken, jolloin sen on sisällettävä riittävästi tunnistetietoa.

Tekoälyä ei saa missään tilanteessa käyttää ilman sen vaikutuspiirissä olevien ihmisten tietoisuutta olemassa olevasta teknologiasta. Henkilökohtaisten tietojen käyttäminen ja tallentaminen edellyttää lisäksi aina suostumusta ja tuon suostumuksen ehtona on, että sen antaja ymmärtää riittävällä tavalla keillä on pääsy dataan ja miten sitä käytetään.

Sosiaalialalla käytetään paljon käsitteitä (esimerkiksi syrjäytyminen, oikeudenmukaisuus), joiden yksiselitteinen määrittäminen on hankalaa. Kehittäjien vastuulla on ohjelmoida tekoäly tunnistamaan sosiaaliset ongelmat, joihin on vaikea löytää yleispätevää määritelmää ja joihin tyypillisesti liittyy vahva subjektiivisuus. Tällöin tekoälypohjaisen järjestelmän tekemään päätöksentekoon voi liittyä osittain tahatontakin puolueellisuutta, epäjohdonmukaisuutta ja satunnaisuutta.

Tekoäly tarvitsee ihmisälyä eettiseksi tuekseen sosiaalialalla

Tekoälylle etiikan opettaminen on verrattavissa siihen, kun lapselle opetetaan moraalisia periaatteita ja sosiaalisia normeja. Tekoäly tarvitsee ohjausta kehittäjiltä ja käyttäjiltään pystyäkseen tunnistamaan hyväksyttäviä ja sopivia toimintatapoja erilaisissa tilanteissa.

Kansalliset ja kansainväliset lait ja standardit pyrkivät varmistamaan oikeudenmukaisen tekoälykehityksen. Eettisyyden vaatimus täydentää lainsäädäntöä, joka ei aina pysy nopean teknologisen kehityksen perässä. Mitä enemmän tekoälyjärjestelmiä otetaan käyttöön ja niille annetaan vastuuta päätöksenteosta sitä tärkeämpää on varmistaa, että ne toimivat ehdottomien arvojen mukaisesti, oikeudenmukaisesti ja järjestelmien elinkaaren aikaiset vastuut ja velvollisuudet ovat selkeät. Tässä tarvitaan sosiaalialan ammattilaisen osallisuutta kehittäjien rinnalla.

Lähteet

Charisi, Vicky, Dennis, Loiuse, Fisher, Michael, Lieck, Robert, Matthias, Andreas, Slavkovik, Marija, Sombetzki, Janina, Winfield, Alan F. T., & Yampolskiy, Roman 2017. Towards Moral Autonomous Systems. arXiv.Org. https://doi.org/10.48550/arxiv.1703.04741

Euroopan komissio 2019. Viestintäverkkojen, sisältöjen ja teknologian pääosasto. Luotettavaa tekoälyä koskevat eettiset ohjeet. Julkaisutoimisto. https://data.europa.eu/doi/10.2759/068692

Gillingham, Philip & Graham, Timothy 2017. Big Data in Social Welfare: The Development of a Critical Perspective on Social Work’s Latest Electronic Turn. Australian Social Work 70 (2): 135–47. https://doi.org/10.1080/0312407X.2015.1134606.

Hallamaa, Jaana & Kalliokoski Taina 2022. AI Ethics as Applied Ethics. Frontiers in Computer Science (Lausanne) 4. https://doi.org/10.3389/fcomp.2022.776837.

Litchfield, Ian, Glasby, Jon, Parkinson, Sarah, Hocking, Lucy, Tanner, Denise, Roe, Bridget & r Bousfield, Jennife. 2023. ‘Trying to Find People to Fit the Tech…’: A Qualitative Exploration of the Lessons Learnt Introducing Artificial Intelligence-Based Technology into English Social Care. Health & Social Care in the Community 2023: 1–11. https://doi.org/10.1155/2023/9174873.

Talvitie-Lamberg, Karoliina, Silvennoinen, Minna, Moilanen, Hannu & Korpela, Jari 2018.Tekoäly sosiaalisen syrjäytymisen ennakoivassa tunnistamisessa – Case THL kouluterveyskysely. Jyväskylän yliopisto. Informaatioteknologian tiedekunnan julkaisuja. No. 62/2018.

Blogin kuvitus: OpenART AI.

Kehotteet:

“automated vehicle controlled by AI

“a painting of a student who is struggling to graduate.”

“a painting of a student who is struggling to graduate and instead of studying the student is cleaning.”

“painting of Artificial intelligence and social work”